标题:Will Humans-in-the-Loop Become Borgs? Merits and Pitfalls of Working with AI

作者:Andreas Fügener; Jörn Grahl; Alok Gupta; Wolfgang Ketter

引用格式:Andreas Fügener, Jörn Grahl, Alok Gupta, Wolfgang Ketter; Will Humans-in-the-Loop Become Borgs? Merits and Pitfalls of Working with AI1. MIS Quarterly 1 September 2021; 45 (3): 1527–1556.

一、摘要

我们分析了人工智能的建议如何影响人类与人工智能之间的互补性,尤其是人类所知而人工智能所不知的领域:“人类独有知识”。在一项包含分析模型、实验研究和模拟研究的多方法研究中,我们的主要发现是,人类的选择会趋向于相似的反应,从而提高个体的准确性。然而,随着人类群体整体个体准确性的提高,个体独有的人类知识会下降。基于这一发现,我们认为人类与人工智能的互动行为类似于“博格人”,即拥有强大个体表现但没有人类个性的机器人。我们认为人类独有知识的丧失可能会在许多人机互动的人工智能决策环境中导致一系列不良后果。我们进一步证明了这种负面影响对“群体智慧”的危害。基于我们实验数据的模拟结果表明,与没有AI辅助的人类群体相比,与AI互动的人类群体效率要低得多。我们建议采取缓解措施以创建能够兼顾两者优势的环境(例如,通过个性化的人工智能建议)。我们表明,此类干预措施在个人和群体智慧境中均表现良好。

二、研究背景

随着AI技术快速发展,AI已在医疗、法律、金融等众多领域成为人类决策的重要辅助。AI-advised decision making系统让人类在做决策前获得AI建议,普遍被视为提升个人决策表现的有效手段。过往文献主要关注如何让AI和人类互补、最大化绩效,并探索了诸如AI不确定性透明度、AI建议解释性等提升人类决策表现的方法。然而,绝大多数研究仅关注准确率提升,而忽略了人类在协作中贡献的独特知识(unique human knowledge),即AI无法覆盖但人类能提供的多样化视角与独到判断。

现有关于AI建议的人类决策研究,鲜有关注AI建议对人类独特知识的影响。在众多协作和群体决策场景中(如wisdom of crowds),人类之间的知识多样性和补充性是集体创新与高质量决策的关键。AI建议如果导致人类行为趋同,则可能削弱人类间的互补性,降低群体智慧的实际效能。本研究首次系统性提出并验证:AI建议在提升个体表现的同时,会抑制人类独特知识,并危害群体层面的多样性优势。

三、研究问题

人工智能建议如何影响人类的决策准确性和独特的人类知识?

如何减轻人工智能建议对人类独特知识的负面影响?

人类独特知识的丧失对群体智慧有何影响?

四、研究假设

H1a: 人类在接受AI建议时,准确率提升。

H1b: 人类在接受AI建议时,独特知识(UHK)损失。

H2a: 提供AI置信度信息,可进一步提升人类准确率。

H2b: 提供AI置信度信息,可缓解UHK的损失(提升多样性)。

H3a: 个性化AI建议不会降低人类准确率(甚至可能提升)。

H3b: 个性化AI建议能提升UHK。

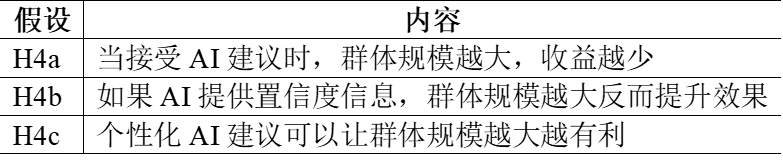

H4a: 在AI建议条件下,随着群体规模增大,群体智慧效应减弱。

H4b: 若AI建议附加置信度信息,群体规模越大,群体智慧效应增强。

H4c: 个性化AI建议下,群体规模越大,群体智慧效应增强。

五、实验方法

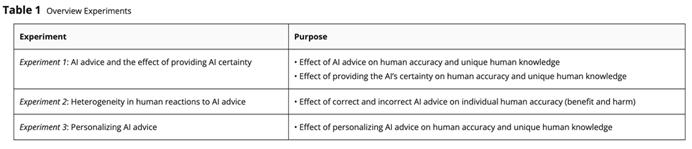

实验概览(见 Table 1 中)

实验任务:图像识别

实验操作流程

参与者需将一个焦点图像分为10个类别之一(例如图像是小黑狗,类名如“Boxer”或“Swiss Mountain Dog”)。

每个类别配有13个示例图片与类名。

图像来自ImageNet数据库,所有受试者识别同样的100张图像。

任务难度不同,例如识别“消防车”较易,但识别某些狗的品种较难。

每次选择后,受试者需报告他们的决策信心程度(从1到4分:非常不确定到非常确定)。

实验条件设置

No AI组:受试者独立完成任务,无AI建议。

AI suggestion组:受试者获得来自GoogLeNet Inception v3的建议(推荐最可能的类别)。

AI基于1000类概率分布,给出概率最高的类别。

在这100张图像中,AI识别正确率为 77%(准确分类了77张图像)。

关键测量指标

Human Accuracy= 受试者正确分类的图像数量 / 总图像数量。

Unique Human Knowledge= 人类正确但AI错误的图像数量 / 图像总数。

实验1:AI建议对人类准确性与人类独特知识的影响

实验目的:检验AI建议和AI可信度(确定性)信息对人类个体决策准确率以及独特人类知识(UHK,指人对但AI错的情形)的影响。

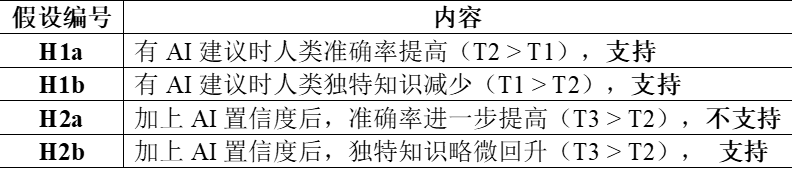

实验假设

实验结果

1. 人类准确率

T1(无AI建议):0.681

T2(有AI建议):0.799(↑11.8%,显著提高,H1a支持)

T3(AI建议+置信度):0.801(与T2无差异,H2a不支持)

说明AI建议显著提高准确率,但额外显示置信度并未带来进一步收益。

2. 人类独特知识

T1(无AI建议):0.123

T2(有AI建议):0.073(显著减少, H1b支持)

T3(AI+置信度):0.087(略微回升,H2b支持)

显示AI置信度缓解了AI建议对人类独特判断力的负面影响。

补充分析:

研究者分析了 AI 建议正确 vs 错误 时,置信度信息的影响:

AI错时,显示置信度提升了人类准确率(+0.059)。

AI对时,人类反而更不信AI,准确率下降。

提供AI置信度,导致人类对AI的信任下降(问卷结果支持),这降低了人类听从AI建议的倾向,符合 Glikson & Woolley (2020) 关于信任-服从关系的研究。

实验2:人类对人工智能建议反应的异质性

实验目的

该实验是探索性的,没有预设假设,目标是研究以下两点:

1. AI建议是否总是有益?

2. 不同人对正确建议和错误建议的反应是否存在差异?

实验设计

被试内实验(within-subjects design)。每位参与者对每张图像分类两次,第一次独立判断(无AI帮助);第二次看到AI建议后,可决定是否修改答案。

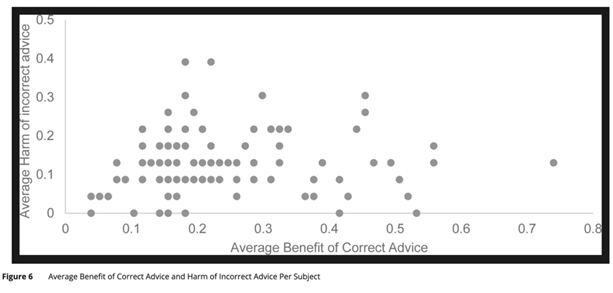

实验结果

1.所有参与者在接收AI建议后表现都有提升,准确率普遍提高,效果比实验一稍强。支持实验一的主要发现,即AI建议对人类有益。

2.个体差异显著。参与者在正确建议的收益和错误建议的损害方面差异很大。图6显示不同个体之间没有一致的模式(即不是谁总是收益高,谁总是易被误导)。

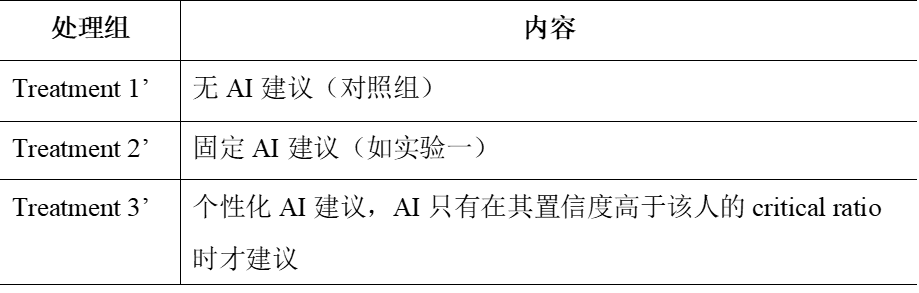

实验3: 个性化AI建议的影响

实验目的:在AI与人类协作决策中,如果AI的建议根据个体的特性量身定做,是否比“一刀切”的AI建议效果更好?

实验处理组

实验假设

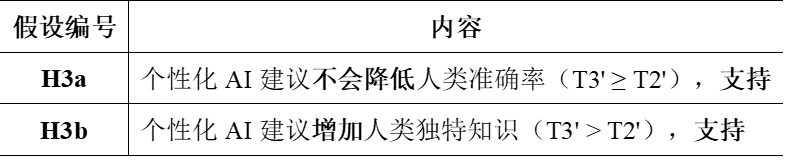

实验结果

1.人类准确率

准确率T2’(0.733) > T1’(0.658),提升 11.5%,显著(p < .001),中等到大效应(d = 0.74)

准确率T3’(0.795) > T2’(0.773),提升 2.2%,不显著(p > .1),小效应(d = 0.14)

支持H3a,个性化AI建议至少不会降低准确率,甚至略有提升。

2.人类独特知识

独特知识T2’(0.074)< T1’(0.108),显著下降(p < .001),中等效应(d = 0.62)。

独特知识T3’(0.097)> T2’(0.074),显著上升(+2.3%,p < .01),中等效应(d = 0.40)。

T3’ 与 T1’ 差异不显著(p > .1)。

支持H3b,个性化AI建议显著缓解了AI建议对人类独特判断力的负面影响。

与实验一中显示AI置信度相似,实验一的Treatment 3 显示AI置信度,让人类自己判断是否采纳。实验三的Treatment 3’ 更进一步,由AI自动决定是否给出建议。两者都提升了人类表现的多样性(保留独立思考),但个性化AI更具自动化、主动性。

若AI建议总是被接受,会造成认知趋同(convergence),人类失去独立思考。多样性下降可能削弱群体智慧(wisdom of crowds)。

实验研究:群体智慧

为了验证AI建议对群体表现的真实影响,研究者设计了一项基于真实实验数据的群体模拟:

每个群体由实验受试者组成,人数从1人到15人,还包括 99人与100人 的大群体。群体决策为成员中出现最多的答案(众数)。若出现并列,随机选择一个。每个群体组合运行1000次蒙特卡洛模拟,对100张图像进行集体分类。

设置三种条件:

1. 无AI建议

2. 固定AI建议

3. AI建议 + 显示置信度

4.个性化AI建议(在实验三中)

实验假设

实验一模拟结果:AI建议抑制群体智慧

固定AI建议的群体:小群体(1~3人)中表现优于不使用AI的人类,但群体规模一旦超过7人,纯人类群体准确率超过AI建议群体,加入AI置信度后情况稍好,但也在11人后被纯人类群体反超。

原因分析:正面建议的边际收益下降,随着群体扩大,也能做出正确判断。错误建议的放大效应增强,更多人盲从AI,使错误建议成为多数答案,导致群体误判。

实验三模拟结果:个性化AI建议效果最佳

在基于实验三的模拟中,研究者引入了个性化AI建议机制——只有在AI判断建议是值得给的时才提示用户。

关键发现:

无论群体规模多大,个性化AI群体始终表现最优,比“固定AI建议”群体最多高出10个百分点。即便是100人群体,个性化建议依然不被“纯人类群体”超越。

AI建议虽然对个体有益,但若设计不当,会削弱群体智慧;唯有个性化AI建议,才能同时提升个体表现与保留集体多样性。

六、理论贡献

1. 发现AI建议的双刃剑效应。本研究不仅验证了已有文献中AI建议能提升个体判断准确率的观点,还首次系统性地指出了AI建议会显著削弱人类的独特知识,从而损害个体之间以及人与AI之间的互补性。

2. 补充了群体智慧中的多样性机制研究。本研究通过模拟实验发现,即使在小群体中(如7人以下),人类群体若能保持独立性,其表现可超越AI辅助群体,突出了认知多样性的重要价值。

3. 提出了个性化AI建议的新机制。构建并验证了一种基于预期损益临界值的AI建议策略,展示了如何通过AI判断自身置信度与人类行为之间的差异性,来实现个性化建议,从而兼顾效率与多样性。

七、实践意义

1. 在人数较少的决策场景中,AI辅助可显著提升人类表现,甚至超越AI本身。

2. 统一AI建议可能抑制群体智慧,群体决策中应避免“千人一面”的建议模式。

3. 基于用户行为和AI置信度的个性化建议机制,具备现实可落地性和推广价值。

资料来源:中智院微信公众号